人与AI的“战争”

59岁的律师黄贵耕决定向AI“宣战”。

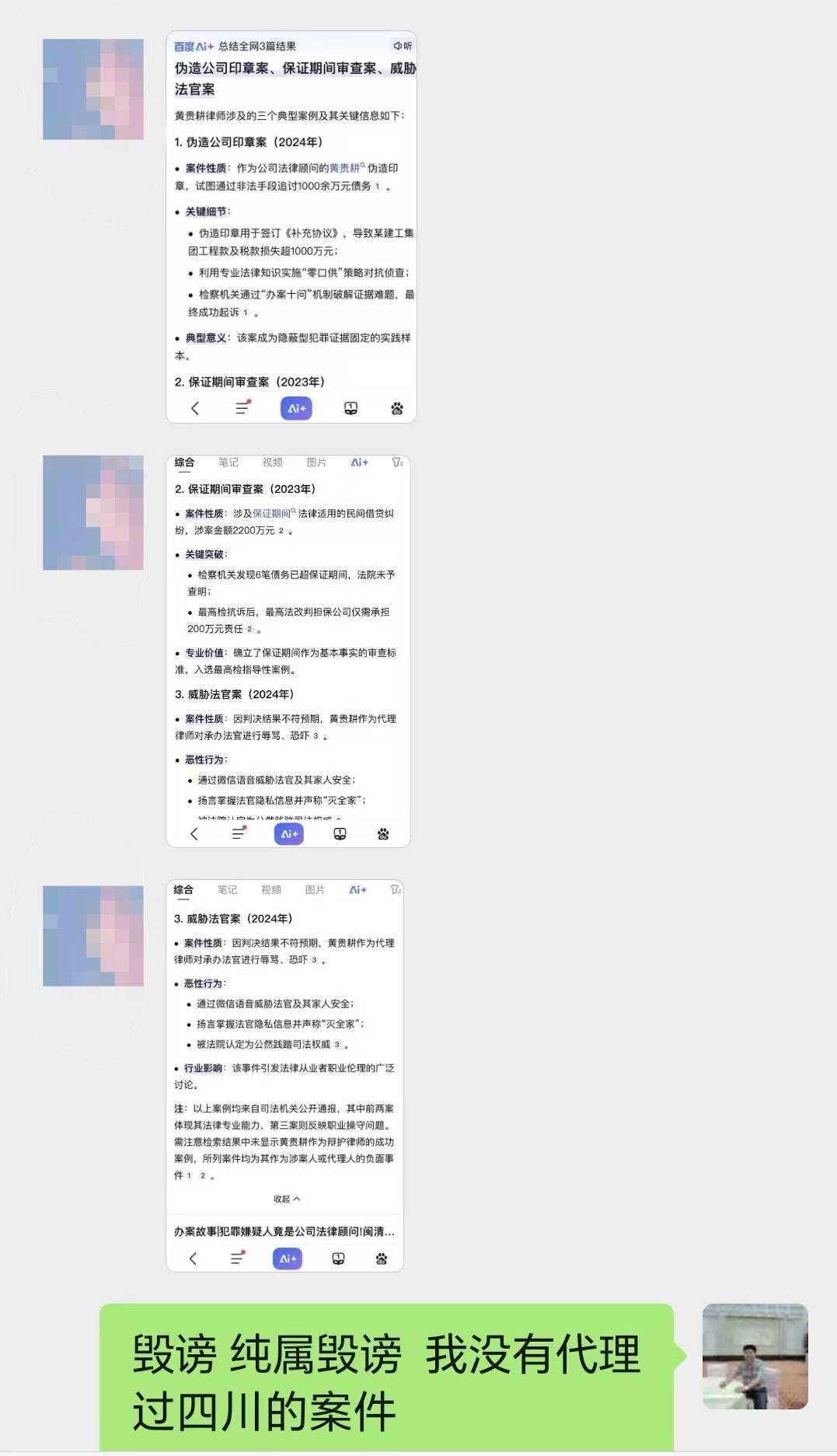

在他提供的证据里,百度AI生成了一段介绍信息,黄贵耕被指威胁法官、向执行局长介绍贿赂,还有伪造印章、非法吸收公众存款等刑事犯罪事实……

黄贵耕发现,在百度检索自己名字时,会被自动关联“律师黄贵耕有没有犯罪”“律师黄贵耕为什么不建议找”等负面信息。他认为百度构建了关于自己的“负面信息传播闭环”。

黄贵耕告诉新京报记者,百度AI生成的虚假信息被传播给他所代理案件的委托人及委托人家属,给他带来巨大的困扰与损失。

2025年9月,他以侵犯名誉权为由,将百度AI背后的百度公司诉上法庭。黄贵耕认为,被视为造福人类的机器“主动伤人”,其开发运营者具有不可推卸的责任。

这并非AI首次与人类“开战”。多位受访者告诉新京报记者,2025年以来,他们同样遭遇了来自机器的“攻击”:各大搜索平台上,AI针对用户生成负面信息,“言之凿凿”地对其判刑、定罪,又或是“挑唆”关联其他负面事件。

人与机器对簿公堂,让包括法官在内的各界人士都感到棘手:“该怎么判?我们也在思考。”一位资深律师提出,为了保护科技创新,人类应当“忍耐”机器犯的错误。也有学界专家对此说法表示反对,认为机器背后的公司应当肩负保护用户权益的责任。

AI“伤人”,“应战”还是“谅解”?这一在模糊边界探索的问题尚未有定论。人类和机器的“战争”仍在继续。

“对手”不是人类

2025年5月21日,黄贵耕收到一位案件委托人发来的四张截图。截图内容是以“黄贵耕律师”为关键词生成的百度AI检索内容。

百度AI总结全网结果显示,“黄贵耕律师”涉及伪造公司印章案、保证期间审查案和威胁法官案。内容的末尾还有段“特别提醒”:“需注意,检索结果中未显示其作为辩护律师的成功案例,所列案件均为其作为涉案人或代理人的负面事件。”

2025年5月,律师黄贵耕收到案件委托人发来的四张截图,截图内容是以“黄贵耕律师”为关键词的百度AI检索结果。受访者供图

看完截图,黄贵耕先是疑惑,继而愤怒。委托方的责问很直接:请律师来打官司,结果律师自己都负面缠身,我们该怎么相信你?黄贵耕激烈地反驳:纯属毁谤,都是没来由的事,或是有人在“搞”我。对于这些解释,委托人并不满意,只是模棱两可地表示再查一下。

黄贵耕最先怀疑是同行恶性竞争,有人故意在网上抹黑自己。他想起自己曾与一位同行有过案源竞争,当天,黄贵耕先向当地司法局提交了一份“伪造网络信息恶意诋毁同行”名义的投诉信。

花了几天时间,黄贵耕才找到真正的“对手”。更换不同的设备,又多次变换检索关键词,他发现,虽然每次的生成内容会有细微差别,但“百度AI总结全网搜索结果”的提示词总是出现在最前端。黄贵耕反应过来,这些信息并不由人书写,而是AI主动生成。

AI还标注出了信息来源:“以上案例均来自司法机关公开通报”。黄贵耕查到,AI声称的上述通报包括人民法院报、福建法治网、最高人民检察院、北京市司法局行政处罚决定书......但一切又全是错的。

黄贵耕发现,所有信息都被“张冠李戴”“移花接木”了:“威胁法官”和“伪造印章”的情节出自新闻报道,但AI将经过匿名处理的“律师黄某”“法律顾问黄某”篡改为他本人,还关联上他所在的律师事务所;“伪造担保函”的内容出自最高检指导的案例,AI又将当事人“黄某平”替换为他的名字;“刑事犯罪被判刑和执业资格吊销”则是将一名匿名处理的黄姓女律师的处罚信息“嫁接”至他的名下。

同为律师,或者同样姓黄,AI就有可能进行信息的挪用,让相关内容被海量用户检索到。“按照这种逻辑,机器会造成无差别伤害,每个人都可能成为AI的受害者,”AI在黄贵耕心里的“客观、理性、中立”形象轰然崩塌。

之后,黄贵耕撤回对律师同行的投诉,转而以“百度AI恶意生成虚假负面信息,严重损害名誉继而摧毁律师执业信誉”为名,向百度公司提起民事诉讼,索赔各项损失109万元。

每个人都可能成为AI的受害者

要打赢机器背后的大公司,并不是一件容易的事,黄贵耕保存了截图与录屏,前往公证处对百度AI检索结果、生成路径固定证据,与代理律师一道准备了起诉状。他甚至准备了一份“百度AI虚构事实侵权第一案”的详细解释稿。

2025年11月,北京海淀区人民法院受理黄贵耕诉百度公司的人格权纠纷案。受访者供图

某种程度上,这也符合黄贵耕的一贯行事风格。严格算起来,他是一名刚执业两年的“新人律师”。此前,他是一名有着近二十年经历的法治记者,“严肃、嫉恶如仇,甚至较真。”黄贵耕认为,他一贯谨慎地维护着个人声誉,这也使得网上有关他的介绍信息极少,更遑论负面。“但现在这一切都被AI毁了!”

2025年11月,这起针对AI主动生成虚假信息的名誉权侵权案件被北京海淀区人民法院受理。

事实上,人和机器之战的“受害者”并非黄贵耕一人,“无差别伤害”正在发生。多位受访者告诉新京报记者,2025年以来,在各平台搜索自己、身边人或公众人物的信息时,AI给出的总结里频繁出现风险信息:或是将人和争议事件关联,或是凭空编造受罚、定罪、判刑这类负面风险情节。

2025年底,37岁的冀承祥在百度检索姓名时,发现自己同样遭受了AI的“诋毁”:百度AI将“组织卖淫罪”放在他的早年真实求学经历之后,称他被法院判处有期徒刑五年六个月,而这一信息同样“嫁接”自另一同名同姓人士。

“我刚考上编,AI就说我涉嫌严重违纪违法,正在接受纪律审查和监察调查。”一位企业职员向新京报记者反映,自从包含她姓名、考试分数和岗位信息的文件在网上公示一段时间后,她的相关信息总是与他人的违法处罚行为关联上,“我同事都暗暗打听我是不是要出事了,感觉领导看我的眼神都很‘怪异’。”

2025年11月底,在治安违法记录封存争议事件中,有网友在搜索治安管理法修改的积极推动者、全国人大代表朱征夫信息时,AI就曾显示朱征夫儿子有吸毒的经历。在社交平台上,这一信息迅速传播,引发针对朱征夫的严重网络暴力。之后,朱征夫报警并公开向媒体辟谣,这一内容才从平台撤下。

北京云嘉律师事务所高级合伙人顾金焰律师告诉新京报记者,2025年7月,他代理了一起诉AI侵犯用户名誉权的案件,当事人的遭遇与黄贵耕十分相似:在用百度搜索引擎检索当事人姓名与近况时,AI生成其“被判刑10年3个月”内容,配以标题“十年牢狱路,前路待光明”,并在生成信息前醒目标注“综合全网54篇真实经验”。而经过核查,这依然是一次手法粗糙的“张冠李戴”,刑期十年的信息源于某篇新闻报道中的同姓人士。

AI为何“攻击”人类?

2025年12月,顾金焰代理的“AI名誉侵权案”在北京互联网法院首次开庭。

第一层共识并不难达成,双方都承认:机器犯了错、惹了祸。“造成这样的误会,我们也深感歉意。”法庭上,平台方代理律师表示,平台搜索引擎的AI功能内容出现了错误,在整合信息内容时,大模型机器将原告与另一被判刑的同姓新闻当事人不当关联,导致了这场诉讼之战。

“但没有人该为AI犯的错承担责任。”接受新京报记者采访时,百度方代理律师将AI的“攻击”行为解释为“AI幻觉”,他认为,面对海量信息,像人一样,AI也会犯错,这是无法避免的事。而错误也并非原告主张的“百度AI故意为之”,错误信息由机器的技术代码自动生成,“不可控、难以避免。”

也因此,百度方代理律师向新京报记者表示,使用AI的平台对这一错误不具有可预见性:“平台将一把‘菜刀’卖出去了,并不知道AI会用它来杀人,为什么要为‘卖菜刀’的行为负责呢?”

这一观点遭到了顾金焰的反驳:“平台不是被动地‘售卖’无差别工具,它不止提供算法模型,还提供生成信息的推送和发布服务。菜刀不会选择主动砍向谁,而基于平台训练数据、算法逻辑和权重打造的AI却可以主动砍向每个人的名誉权,这是出厂时就存在的‘错误’。”他认为,平台对这一问题采取了放任的态度,应当为AI承担侵权责任。

新京报记者从多方获悉,截至发稿,该案尚未宣判。

2026年1月初,发现AI搜索生成针对他的“组织卖淫罪”错误信息后,冀承祥向百度发送邮件说明相关情况,并希望得到处理反馈。受访者供图

对于长期从事搜索引擎AI开发业务的微软资深工程师王斌(化名)而言,平台的技术设计、配套措施和监管审核跟不上,这场人与机器的“战争”并不难理解。从技术层面来看,此类案件中AI的“攻击”现象属于“低级错误”:网页内容语缺乏深度语义分析,无法区分不同个体身份,又缺乏了多轮语义校验审核和把关机制。

王斌表示:“技术层面完全可以实现‘风险信息分级验证’,目前国际上也已经有平台落地相关机制。”但是,百度的AI产品服务或许过于粗糙,这很大概率取决于平台的取舍平衡:“背后可能是节省预算、减轻服务器负载的商业考量,更精细的多轮校验流程意味着更高的算力和成本投入。”

百度和其他平台是否可以实现风险信息分级验证,新京报记者联系包括百度在内多家接入AI功能的平台方人员,截至发稿,未获有效回复。

黄贵耕也试过在其他搜索引擎上输入“黄贵耕律师”等关键词进行搜索,他发现,大部分平台的AI功能并不会将其姓名身份关联负面虚假信息,甚至会主动标注“被处罚的黄姓匿名人士不是黄贵耕律师”。他认为,AI的形象是“恶”是“善”,仍然由其背后的平台控制。

多位受访者指出,被AI“伤害”后,他们先是愤怒,之后便寻找反馈、申诉途径:“找了半天反馈入口,甚至找上了平台客服,即使多次投诉,也还得等待好多天,内容才可能被下架。”

2026年1月初,发现AI搜索生成针对他的“组织卖淫罪”错误信息后,冀承祥向百度发送邮件说明相关情况,百度随后向其致电核实情况,并将这一问题解释为“AI抓取有误,后续将加强对生成结果的监管”。但截止发稿,冀承祥发现,关于他的错误信息仍未得到完全更正或删除。

一位受访者提供的截图显示,她2025年9月反馈的错误信息内容,也至今未得到处理反馈。

新京报记者以用户名义咨询一名负责百度搜索AI业务线的工作人员,对方表示,自2025年年初推出AI搜索功能,他们便收到一定数量的用户反馈,其中不乏负面、投诉内容:“确实有人指出AI生成了错误的内容,也有不当关联信息的情况。”但针对这一问题,对方并未给出“用户可以进行投诉反馈”外的解决方案。

应当“谅解”AI犯错吗?

对于传统的网络服务场景,发现被侵权后,用户向平台提供举证材料,平台核实后予以删除。这类“通知-删除”模式是常规解决方案。但是,在此前办理过涉AI侵权类案件的北京互联网法院法官刘承祖看来,相较于传统的网络服务提供者,人工智能服务提供者在技术特征、数据内容处理和内容展示等方面存在显著差异,这使得“通知-删除”规则能否直接类推适用于人工智能服务提供者的侵权行为成为实践中争议的焦点。

“人工智能生成内容究竟属于什么?是单纯呈现平台上已有的公开信息,还是属于平台创作的作品?换言之,AI在其中究竟只是扮演了被动的信息展示者角色,还是已然成为相对主动的信息生成整合者,其技术是中立的还是有偏向的?平台应当承担多少注意义务?‘通知-删除’规则、技术中立原则是否适用?这都需要根据AI算法模型背后的训练数据、应用逻辑综合判断,我们也无法下一个普适性的结论,需要结合个案的技术细节、侵权场景等综合分析认定。”

他表示,在人工智能生成物引发的人格权侵权纠纷案件中,司法实践正面临“法律适配”与“规则探索”的双重挑战:一方面,现有法律框架难以完全适配AI技术的快速迭代,法律法规层面仍存在一定的模糊地带。另一方面,在现有法律框架下,针对“AI侵权”案件可供参考的裁判案例数量并不多,在司法实践中仍需不断探索完善人工智能服务提供者的权责边界。

对于这场人与机器的“战争”,究竟站在哪方,各方的考量并不相同。

“为保护技术创新,社会需要给予AI试错的空间,一定程度上容忍此类情况的发生。”一位长期研究知识产权领域的高校法学教授认为,他理解被侵权用户的处境,但在当前场景下,当公民人格权与企业技术创新产生冲突,且平台过错不明显时,应当适当倾斜于技术创新者:“这是对大模型创新的保护与激励。”

“整个互联网时代,日本和欧洲因过严的监管和过高的要求,阻碍了全球性的创新型互联网公司的成长,而中国和美国(这类公司)则不断涌现、蓬勃生长。”他进一步解释。

“法律与司法在鼓励技术发展与保护个人权利间寻求平衡点,不应简单要求公众‘容忍错误’。”长期研究数据法治领域的华东政法大学刑事法学院副教授、上海市数字化转型与数字法治建设研究创新团队研究员房慧颖给出了不同的立场。

她认为,当技术应用对公民名誉权等法益造成现实且严重的损害时,法律必须提供有效救济。

她告诉新京报记者,“通知-删除”这一后端补救机制难以全面规制平台的行为,“应当升级平台治理规则,履行保证人的义务,而非放任错误内容或有害内容生成。”平台向公众提供此类服务,理应承担更严格的研发注意义务。

她提出,“分级管理”或许是破解这一两难困境的关键。“平台应当构建精细化的治理体系:对于普通类别信息,例如生活资讯、娱乐消息,可以适当简化审核流程。但涉及‘违法’‘犯罪’等可能严重影响公民声誉的敏感信息时,必须使用权威数据库,或要求多重交叉信源验证,确保信息准确。”

这一方案也得到了资深AI工程师王斌的认可。他强调,头部AI企业作为行业标杆,理应承担起风险信息多重验证的主体责任,这既是合规要求,也是行业可持续发展的基础。

“随着技术迭代,公众对AI检索精度和可靠性的期待只会越来越高。”刘承祖认为,随着技术不断发展,AI检索的精度和可靠性也会逐步提高,他希望能通过典型案例的裁判指引,推动人工智能技术服务提供者加强技术应用的风险防控,优化平台算法设计,推动人工智能技术在合法合规的轨道上健康发展。

人与机器的“战争”仍在继续,两起诉讼的当事人均选择不“谅解”。黄贵耕表示,除了要一个道歉,他还希望借此为人类“讨个公道”:人在机器、大公司面前是弱势,凭什么要我“谅解”你?

新京报记者 胡倩 实习生 申钰棋

编辑 胡杰 校对 赵琳